Файл robots.txt создается специально для поисковых ботов, чтобы они знали куда идти и индексировать, а куда вход запрещен. Если неправильно его настроить, вы можете вообще не попасть в поиск или попасть только у некоторых.

Файл robots.txt создается специально для поисковых ботов, чтобы они знали куда идти и индексировать, а куда вход запрещен. Если неправильно его настроить, вы можете вообще не попасть в поиск или попасть только у некоторых.

Чтобы не было проблем с продвижением и индексацией статей, вам нужно знать, как создать robots txt для всех поисковиков. Это занимает мало времени, но после этого вы будете спокойны.

Как создать robots txt

Некоторые вебмастера и вовсе обходятся без него (в основном, конечно, по незнанию). С одной стороны это разумно для новичков – так вы точно не закроете от поисковых роботов нужную информацию. Но с другой стороны, этот небольшой файл защищает личные данные и не дает спам-ботам просматривать информацию на сайте.

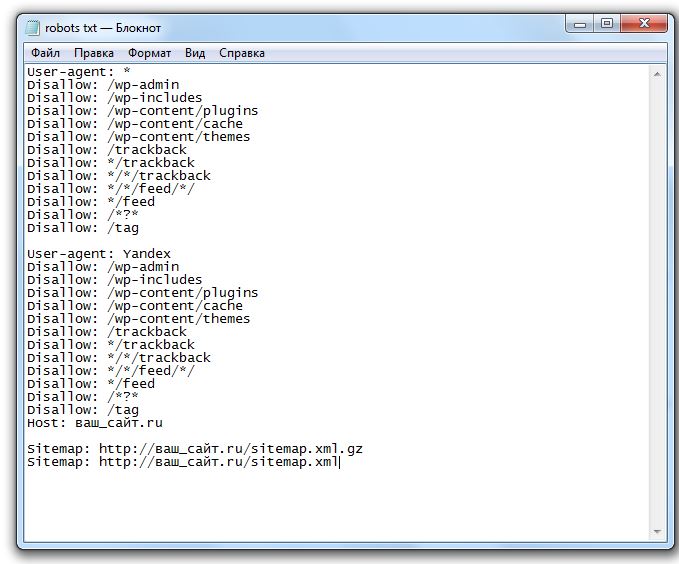

Начинающим блоггерам я рекомендую использовать шаблоны. К примеру, шаблон robots txt для WordPress Скачать. Скачайте и исправьте «ваш_сайт.ru» на название вашего сайта (к примеру, яработаюдома.рф).

Расшифровка значений:

- User-agent: * – вы обращаетесь сразу ко всем поисковым системам, Yandex – только к Яндексу.

- Disallow: перечислены папки и файлы, которые запрещены для индексации

- Host – пропишите название вашего сайта без www.

- Sitemap: ссылка на XML-карту сайта.

Файл поместите в корневую директорию сайта с помощью Filezilla или через сайт хостера. Скидывайте в главную директорию, чтобы он был доступен по ссылке: ваш_сайт.ру/robots.txt

Он подойдет только для тех, у кого стоят ЧПУ (ссылки прописаны словами, а не в виде p=333). Достаточно зайти в Настройки – Постоянные ссылки, выбрать нижний вариант и в поле прописать /%postname%

Robots txt для всех поисковиков

Некоторые предпочитают создавать этот файл самостоятельно:

Для начала создайте блокнот на компьютере и назовите его robots (не используйте верхний регистр). В конце настроек его размер не должен быть больше 500 кб.

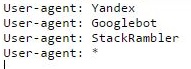

User-agent – название поисковой системы (Yandex, Googlebot, StackRambler). Если вы хотите обратиться сразу ко всем, поставьте звездочку *

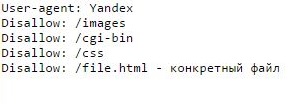

А затем укажите страницы или папки, которые нельзя индексировать этому роботу с помощью Disallow:

Сначала перечислены три директории, а потом конкретный файл.

Чтобы разрешить индексировать все и всем, нужно прописать:

User-agent: *

Disallow:

Настройка robots.txt для Яндекс и Google

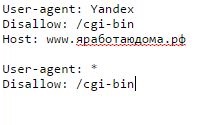

Для Яндекса обязательно нужно добавить директиву host, чтобы не появлялось дублей страниц. Это слово понимает только бот от Яндекса, так что прописывайте указания для него отдельно.

Для Google нет никаких дополнений. Единственное, нужно знать, как к нему обращаться. В разделе User-agent нужно писать:

- Googlebot;

- Googlebot-Image – если ограничиваете индексацию изображений;

- Googlebot-Mobile – для мобильной версии сайта.

Как проверить работоспособность файла robots.txt

Это можно сделать в разделе «Инструменты для веб-мастеров» от поисковика Google или на сайте Яндекс.Вебмастер в разделе Проверить robots.txt.

Укажите ссылку на ваш сайт и посмотрите, нет ли ошибок. Обычно никаких проблем не возникает.

Если будут ошибки, исправьте их и проверьте еще раз. Добейтесь хорошего результата, затем не забудьте скопировать правильный код в robots.txt и залить его на сайт.

Теперь вы имеете представление, как создать robots.txt для всех поисковиков. Новичкам рекомендую использовать готовый файл, подставив название своего сайта.